L’éthique de l’IA est bonne pour les affaires. Il est temps pour les managers et les spécialistes de l’IT de prendre les devants et d’assumer un rôle de leadership en ce domaine. Voici comment.

L’éthique de l’IA est bonne pour les affaires. Il est temps pour les managers et les spécialistes de l’IT de prendre les devants et d’assumer un rôle de leadership en ce domaine. Voici comment.

Après plusieurs expériences en Growth Marketing en startup, il est évident de reconnaître que les programmes de viralité sont souvent un canal extrêmement puissant pour générer de l’acquisition « saine ». Alors que les canaux traditionnels – référencement naturel (SEO), publicités payantes sur …

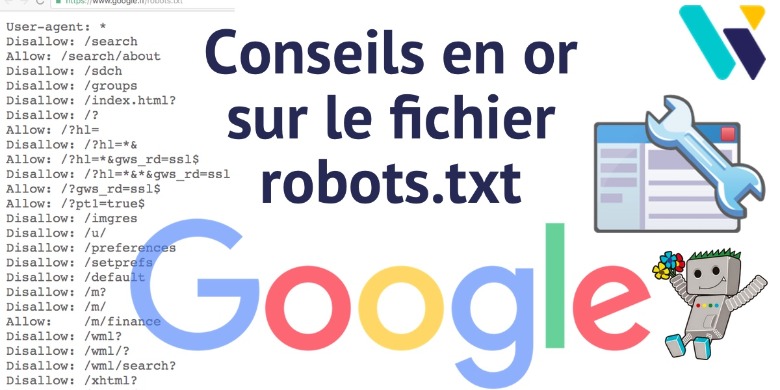

Le fichier robots.txt permet de bloquer le crawl des moteurs de recherche pour certaines URL ou parties d’un site. Ce dossier détaille tout, avec plein de conseils SEO que vous ne connaissiez peut-être pas…Cet article écrit par Olivier Duffez a été publié sur SEO : 21 conseils sur le fichier …

Zendesk livre ses 3 conseils pour utiliser les canaux de conversation comme levier d’optimisation de son expérience client. Transformer son service client

Dominique Despres, VP Sales France chez Uberall, livre son point de vue d’expert et dévoile de précieux conseils pour aider les entreprises à dynamiser leur stratégie de marketing digital à l’échelle locale et favoriser une expérience client unique…

Sauvegarder toutes les données critiques, ne jamais arrêter les correctifs, se méfier du phishing, supprimer les privilèges ; Ketty Cassamajor explique dans cette tribune comment se méfier de ces attaques devenues incessantes.

Quand on est un créatif, le manque d’inspiration ou le syndrome de la page blanche peut être une vraie source d’anxiété. Voici quelques ressources et conseils pour soigner son esprit créatif.

Si la science des données peut avoir un impact significatif sur des décisions cruciales prises dans le secteur public, le sujet reste complexe et difficile à traiter.

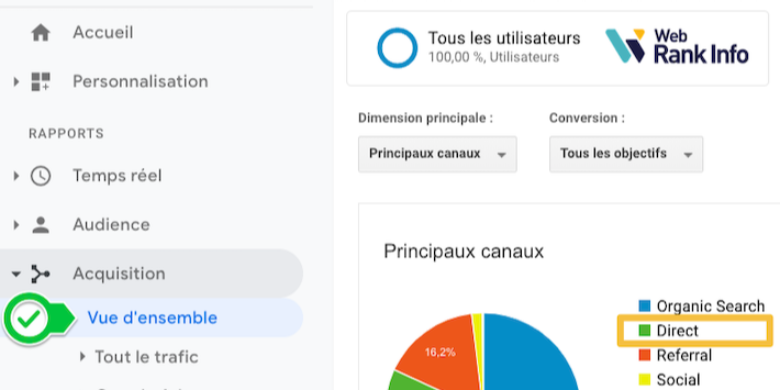

Dans votre compte Google Analytics, certaines visites sont regroupées dans le support “direct”. En théorie il s’agit des visites issues des internautes qui tapent directement votre URL ou qui accèdent au site via leurs bookmarks. Mais la réalité est toute autre ! Vous trouverez dans ce tutoriel un …

Découvrez 5 idées pour optimiser les résultats SEO de votre site e-commerce. Des conseils simples et pratiques facilement applicables.